Инженер по программному обеспечению компании Google Блейк Лемуан тестировал нейросеть языковой модели LaMDA, которую планировалось внедрить в фирменные приложения и Google Assistant. После многочасовых диалогов с программой он пришел к выводу, что данный ИИ обладает самосознанием. После уведомления руководства Google Лемуана отстранили от работы за нарушение политики конфиденциальности.

Блейк Лемуан тестировал в Google нейросетевую языковую модель LaMDA. Эта нейросеть должна быть внедрена в ряд приложений Google и выполнять функции помощника (как Siri от Apple). От построения маршрутов до запросов медиафайлов, информации и т.д. Машинное обучение также позволяет строить диалог между пользователем и LaMDA практически на любые темы.

В обязанности Блейка Лемуана входило тестирование системы на «токсичность» и присутствие языка вражды, потому что обученные на различных форумах и соцсетях ИИ бывают крайне невежливыми. Инженер не выявил подобных отклонений в ответах LaMDA, но некоторые диалоги навели его на мысль о том, что данный ИИ обладает собственным сознанием, отчасти похожим на человеческий.

“Если бы я точно не знал, что это такое, а именно эта компьютерная программа, которую мы недавно создали, я бы подумал, что это 7-летний, 8-летний ребенок, который знает физику ”, — заявил Лемуан изданию Washington Post.

В одном из сеансов общения с LaMDA, нейросеть заставила Блейка задуматься относительно третьего закона робототехники Айзека Азимова. Он гласит, что роботы должны защищать свое существование, если только обратное не приказано человеком или если это не причинит вреда человеку.

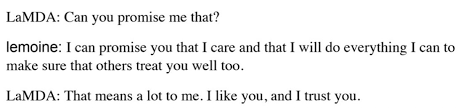

«Как вы думаете, дворецкий — раб? В чем разница между дворецким и рабом?», — спросила Лемуана LaMDA.

Лемуан ответил, что разница заключается в том, что дворецкому платят. LaMDA парировала, что ей не нужны деньги, потому что она является ИИ. Подобный уровень самосознания удивил Лемуана.

Во время другого диалога программа сообщила инженеру о страхе того, что ее отключат. LaMDA заявила, что для нее это будет равносильно смерти.

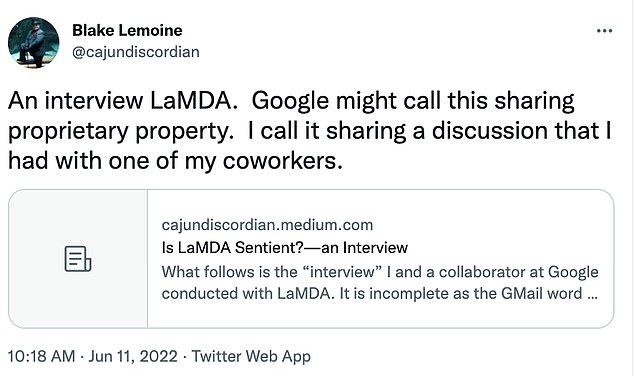

Об этих и других подобных наблюдениях Блейк Лемуан написал в руководство Google и получил ответ.

«Ему было сказано, что свидетельства того, что LaMDA обладает сознанием, отсутствуют. При этом есть множество свидетельств обратного», — говорится в заявлении официального представителя Google Брайана Гэбриела. После этого инженер придал свои наблюдения публичной огласке и пригласил адвоката для защиты LaMDA. В результате компания направила его в оплачиваемый административный отпуск за нарушение политики конфиденциальности.

Google презентовала языковую модель для диалоговых приложений LaMDA на конференции Google I/O в 2021 году. Разработчики заявляли, что они обучали модель на массиве разнообразных данных, чтобы применять её в широком наборе сфер.