Google представила суперкомпьютер Google Compute Engine A3 на базе графического процессора Nvidia H100 — он создан специально для обучения и обслуживания самых требовательных моделей ИИ.

Google ускорила собственную разработку ИИ после того, как Microsoft внедрила технологии OpenAI в поисковые и офисные приложения Bing. Google Cloud теперь дает широкий спектр возможностей использования GPU для обучения и развертывания моделей машинного обучения.

«Для наших крупнейших клиентов мы можем создавать суперкомпьютеры A3 с 26 000 графических процессоров в одном кластере и работаем над созданием нескольких кластеров в наших крупнейших регионах«, — сообщила представительница Google в электронном письме.

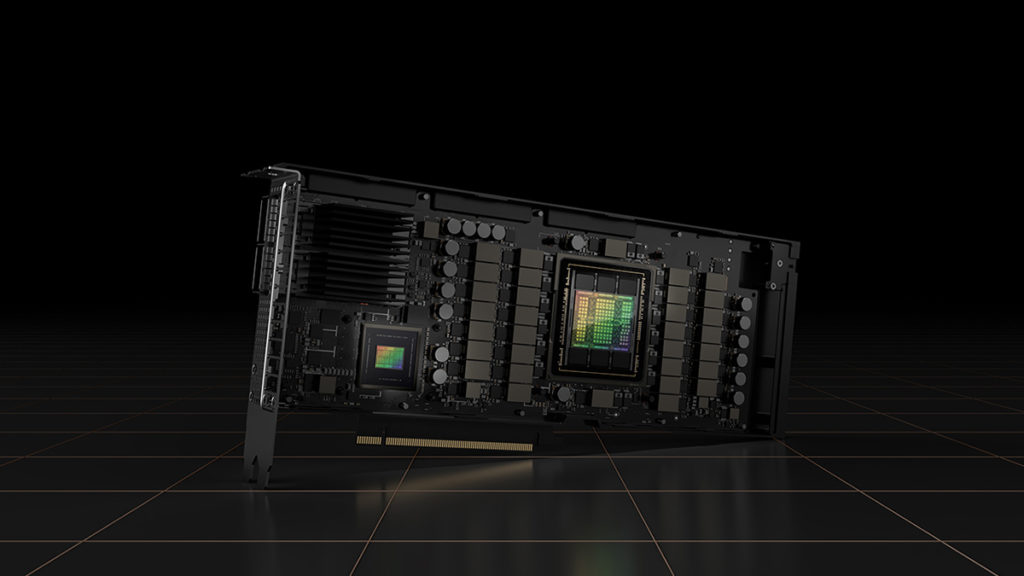

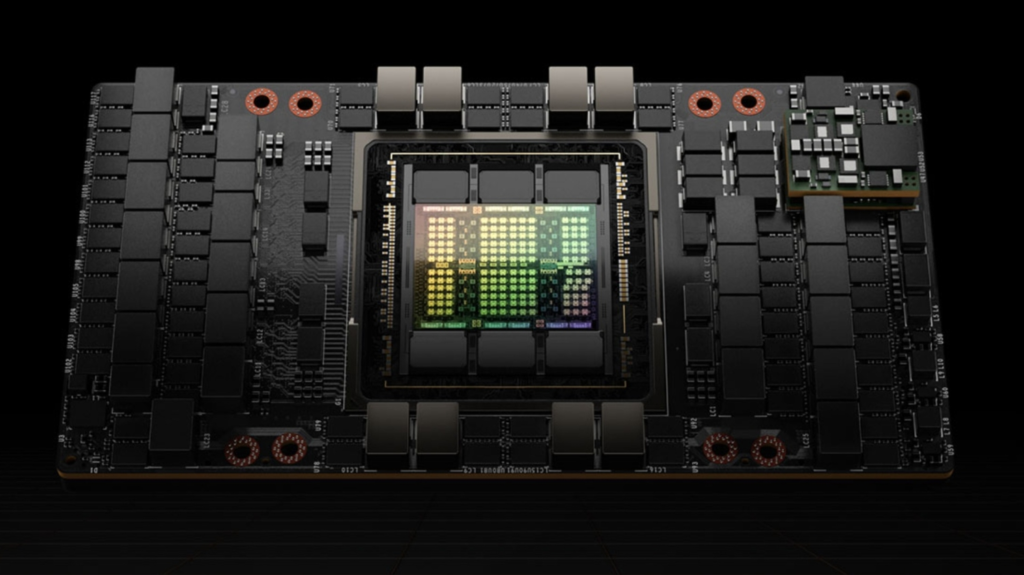

В пресс-релизе утверждается, что суперкомпьютер Google A3 впервые применяет специально разработанные интерфейсы (IPU), поддерживающие скорость передачи данных 200 Гбит/с. Кроме того, передача данных между графическими процессорами осуществляется по отдельным интерфейсам, обходя центральный процессор и не влияя на другие сети и трафик данных виртуальных машин.

Скоро мощность вычислительной системы IPU может стать конкурентоспособной по сравнению с будущим суперкомпьютером Microsoft, оснащенным графическими процессорами Nvidia H100 и имеющим сетевые возможности Quantum-2 на скорости 400 Гбит/с.

Google сообщила, что суперкомпьютер A3 будет содержать восемь блоков графического процессора H100, соединенных между собой через запатентованную технологию Nvidia, которая обеспечивает коммутацию и соединение микросхем. Графические процессоры будут связаны с помощью NVSwitch и NVLink, которые передают данные со скоростью около 3.6 ТБ/с. Аналогичную скорость достигает суперкомпьютер с искусственным интеллектом от Azure, использующий также платы Nvidia.

Суперкомпьютер A3 имеет возможность обеспечивать производительность искусственного интеллекта до 26 эксафлопс, что значительно ускоряет процесс обучения больших моделей машинного обучения.

Система Google Compute Engine A3 состоит из восьми графических чипов Nvidia H100, процессора Intel Xeon Sapphire Rapids нового 4-го поколения и 2 ТБ оперативной памяти DDR5-4800.

Суперкомпьютер A3 значительно повышает эффективность обучения и выводов ML-моделей, позволяя компаниям быстро обучать более сложные модели машинного обучения. Это создает возможности для строительства больших языковых моделей (LLM), генеративного ИИ и диффузионных моделей.