Бывший сотрудник компании OpenAI (разработчик ChatGPT) из команды Superalignment Леопольд Ашенбреннер опубликовал 165-страничный документ о стремительном развитии искусственного интеллекта в ближайшее десятилетие. Сильный ИИ (AGI) появится уже в 2027 году и по уровню интеллекта не будет уступать человеку.

В материале «Осведомленность о ситуации: Предстоящее десятилетие» Ашенбреннер на основе своего опыта работы в OpenAI делает ряд смелых прогнозов.

Глава I. Когда создадут ИИ, который будет умнее человека?

В первой главе специалист утверждает, что американский бизнес готовится вложить триллионы долларов в развитие вычислительных мощностей для усиления систем искусственного интеллекта. Цель — создать сильный ИИ, который в профессиональной терминологии называется AGI (Artificial general intelligence). Он появится к 2027 году.

Экс-сотрудник OpenAI пришел к этому выводу, проанализировав темп прогресса в области машинного обучения. С 2019 по 2023 год (от GPT-2 до GPT-4) был пройден путь от моделей с интеллектом дошкольника до моделей, сравнимых с одаренным старшеклассником.

Всего за 4 года произошел гигантский скачок и ожидается, что к 2025-2026 годам ИИ превзойдет выпускников колледжей, а к концу этого десятилетия станут намного умнее, чем человечество.

Рост возможностей систем искусственного интеллекта обеспечивают многомиллиардные инвестиции. Ашенбреннер предупреждает, что этот прогресс приведет к большой конкуренции в области ИИ между США и Китаем. Впоследствии, все это может вылиться в полномасштабный конфликт между двумя государствами, считает он.

Глава II. Цукерберг, Amazon и Microsoft создают сверхинтеллект

Во второй главе Леопольд Ашенбреннер считает, что когда ИИ достигнет уровня, сопоставимого с человеком (AGI), прогресс на этом не остановится. Сотни миллионов AGI смогут автоматизировать ИИ-исследования, «сжав» десятилетие прогресса в один год. Это означает быстрый переход от человеческого уровня к ИИ-системам, которые превзойдут человека.

Ашенбреннер сравнивает AGI и сверхинтеллект с атомной и водородной бомбами, говоря о том, что атомная бомба является просто эффективным оружием, а водородная бомба является мощным устройством, которое может уничтожить все на своем пути. Есть большая вероятность, что сверхинтеллект будет обеспечивать военное преимущество некоторым странам. Это может привести человечество к самому напряженному и нестабильному периоду истории.

До конца этого десятилетия, по мере роста доходов от ИИ, триллионы долларов будут вложены в создание GPU (графических процессоров), дата-центров и электростанций. Чем активнее будет развиваться AI, тем быстрее произойдет промышленная мобилизация, в том числе увеличение производства электроэнергии на десятки, а может на сотни процентов.

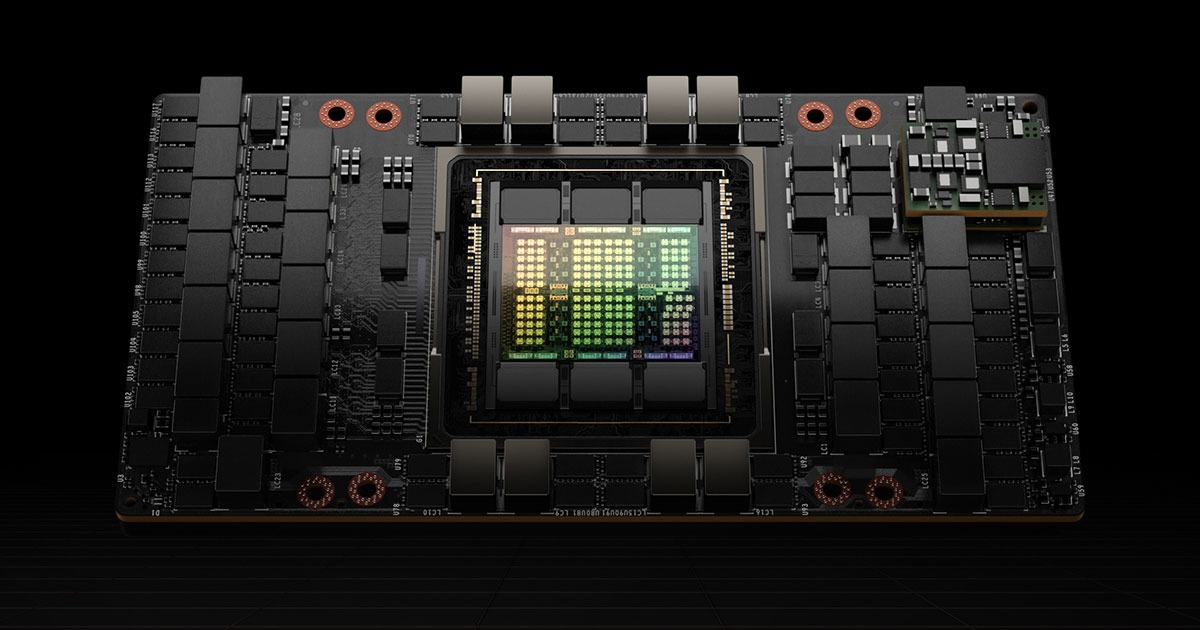

Доказательства, которые приводит Леопольд Ашенбреннер: Марк Цукерберг купил 350 тысяч специализированных для работы с ИИ процессоров Nvidia H100, компания Amazon приобрел дата-центр мощностью в 1 ГВт рядом с атомной электростанцией, а Microsoft и OpenAI работают над кластером стоимостью 100 миллиардов долларов (это практически стоимость Международной космической станции).

Тем не менее, главные национальные лаборатории, которые занимаются разработкой искусственного интеллекта, пока считают безопасность второстепенной задачей.

Ужу спустя несколько лет станет ясно, что секреты разработки AGI будут иметь решающее значение в области национальной обороны. Потребуется продвинутая система безопасности, как на военных объектах, указывает в своем отчете бывший сотрудник OpenAI.

Нужно полностью изолировать дата-центры с внедрением системы безопасности. Специалисты должны работать в закрытых защищенных помещениях со строгим контролем со стороны спецслужб, утверждается в документе. На данный момент ведущие лаборатории не готовы к защите от полномасштабного промышленного шпионажа и у них нет времени на подготовку, учитывая быстрые сроки создания систем ИИ.

Главы IV и V. Сценарии развития сверхинтеллекта

В последних двух главах Ашенбреннер рассматривает возможные сценарии, которые связаны с развитием ИИ и достижением сверхинтеллекта (ASI).

Какие могут быть препятствия для «интеллектуального взрыва»? Например, ограниченные вычислительные мощности и их недостаток для проведения экспериментов, которые могут замедлить прогресс, но не остановит рост ИИ-систем.

На протяжении всего документа Леопольд Ашенбреннер призывает очень серьезно отнестись к перспективе появления сверхразума. Для человечества это бесспорно может дать большие возможности и снизить временные затраты на решение сложных задач, но ошибки и просчеты могут привести к мировой катастрофе. И самое главное — необходимо обеспечить надежный контроль ИИ на каждом этапе его развития.

Кто такой Леопольд Ашенбреннер?

Леопольд Ашенбреннер был уволен из американской компании OpenAI в этом году. Он утверждает, что из-за поднятия вопроса о недостаточных мерах безопасности в компании. Сотрудник делился некими документами, которые, по мнению работодателя, содержали конфиденциальную информацию.

Но Ашенбреннер отрицает, что в опубликованном документе были секретные сведения. В нем лишь упоминается о планах компании по созданию AGI (общего искусственного интеллекта, ИИ с разумом человеческого уровня) к 2027-2028 годам.

Стоит отметить, что Леопольд Ашенбреннер один из немногих сотрудников компании, который не подписал письмо с просьбой о возвращении Сэма Альтмана на пост главы компании после того, как совет директоров его уволил.

Команда Superalignment,в которой состоял Леопольд Ашенбреннер занималась контролем развития AI. Главная цель команды заключалась в удержании искусственного интеллекта в безопасных рамках, чтобы ИИ не стал непредсказуемым и не нанес вреда человечеству.

Следите за новостями в наших социальных сетях: ВКонтакте и Telegram.